| 送交者: 炫笔伏逼[♂☆★★★不闻风知★★★☆♂] 于 2024-04-22 23:10 已读 1600 次 | 炫笔伏逼的个人频道 |

一、科技以好玩为本

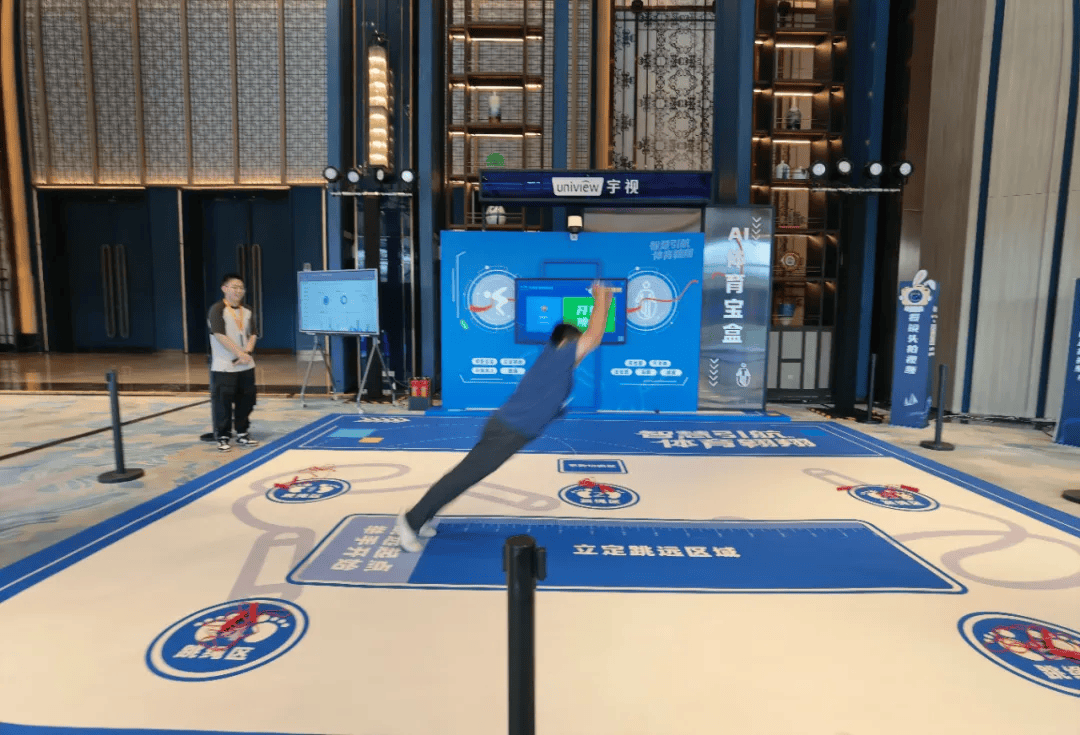

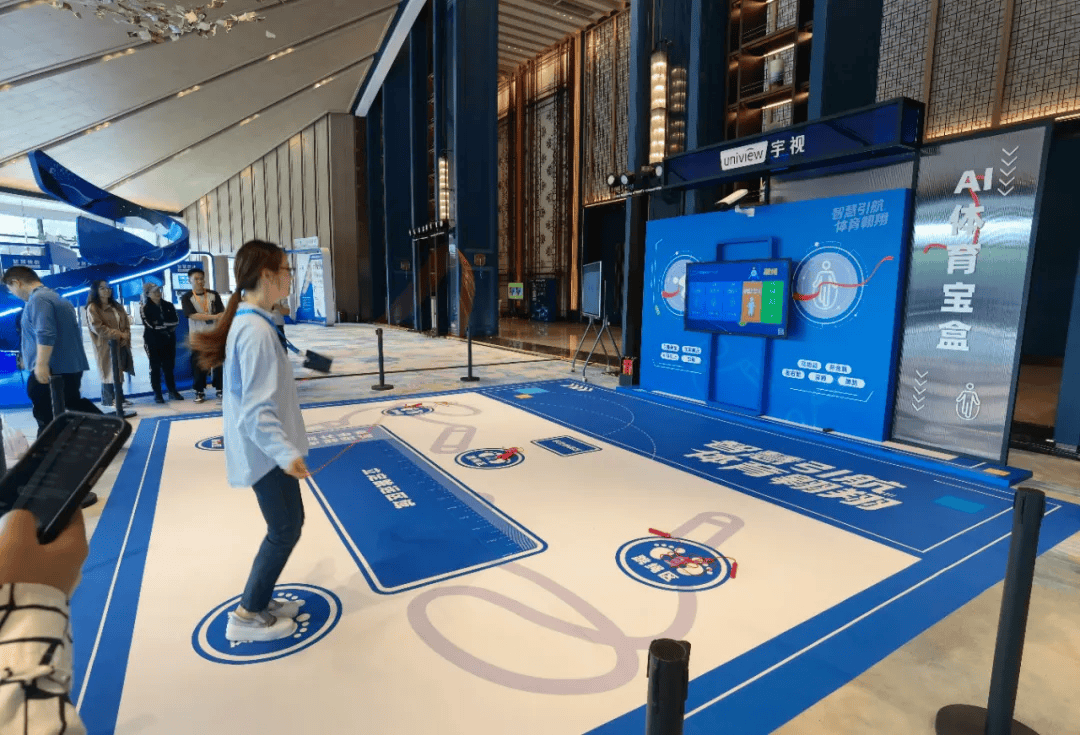

我本来收集了大量人工智能的资料,从基本原理到技术再到应用整理了系统的新理论分析。可是亲自体验过人工智能的全新应用之后,我就觉得那些可以放后面再说了。人工智能到底有什么用?今天参加一个产品展示和体验过后,的确是大开眼界。这个展示和体验是由国际领先的人工智能应用技术和产品提供商宇视科技年度合作伙伴大会上提供的(2024年4月16日乌镇召开)。虽然很多产品功能我过去都知道,之前在展厅和网上看过相应产品,甚至很清楚大量具体的技术参数,但很多产品真的是只有亲自体验过后才知道,原来这东西居然还能做成这样。这是我参加所有这类活动中运动量最大、最累的一次,在最新人工智能加持下的短跑、跳绳、立定跳远、踢足球......原来还可以这么玩。

6park.com 50多种体育活动项目,还可以一边运动一边测试背唐诗

河南学校实际案例视频

可能有人会问,类似功能原来也有,这个突破是什么?其实,十几年前类似功能我就见过,也尝试过,但体验并不好。显然,如果只有一个人可以玩,不仅成本高,而且很难真正具有实用性。因为一个人在那里站着玩,其他人在旁边看着,不太自然,也不具有竞争性,并且当时软件抗干扰能力很不好,旁边稍有干扰就会出错。由于技术能力的显著提升,现在可以支持5个人同时玩各种体育项目。这不仅成本低,而且具有竞争性,这样才能使人们有很大兴趣去玩。很多人工智能功能或应用类型都是类似的,演示技术早就有,但它真正的应用爆发点在什么水平是一个很关键的问题。

瞬间给出报告和各瞬间运动照片查看分解动作是否规范

人工智能短跑视频。我试跑了一下,高一(3)班汪涛同学50米成绩9秒1,居然及格了。

人工智能足球。因为宇视总裁张鹏国喜欢踢足球,所以这个软件是他自己亲自当测试工程师的产品。

还有更多好玩的。拍照自动消除身边其他路人,当然你还可以专门选择保留自己的朋友和家人。

再选择一张背景,瞬间就穿越到印度泰姬陵

自动生成游览视频VLOG。这个在很多旅游点,博物馆等都可以应用。自动生成在旅游点的短视频。请点击上面自动生成的我参加大会的VLOG视频看看效果。

二、中美人工智能竞争并不像很多人想象中的那样

当2023年初Chat GPT火爆全网的时候,普遍的说法是大模型将带来一场革命,中国将被远远甩在后面。给出的理由主要有三个,似乎每一个都让人绝望:

Chat GPT的迭代速度之快甚至会超过中国学习的速度。算法还不是最重要的,大模型需要喂给它海量的数据。根据维基百科显示,截至2020年3月25日,W3Techs预测中文数据在全球互联网前100万网站上的内容占比只有1.3%,排名第10位,排名第一的英文是59.3%。俄语(8.4%)、西班牙语(4.2%)、德语(2.9%)、土尔其语(2.9%)、波斯语(2.8%)、法语(2.8%)、日语(2.4%)、葡萄牙语(2.2%)。这个统计数据是否准确是值得讨论的另外一个问题,但英语使用最为普遍,即使很多中文或其他语言的网站也提供了英文页面,这个的确是事实。另外一个原因是W3Techs统计的是网站的数据,而中文互联网因为APP的发达,很多中文内容已经不在传统的网站上,而是在移动手机APP平台上。根据CNNIC的统计数据,中国在移动互联网流量近几年在保持每年近40%的高速年增长率的同时,网站数量却是在下降的。这个现象也对应了中文流量向APP平台转移的事实。但无论原因是什么,因为APP平台上的数据相对封闭,一般的大模型平台拿不到这部分数据。因此,无论中文的互联网内容事实上是多少,的确都带来了一个对大模型的发展来说相同的结果:可供大模型训练的中文数据相对英文少很多。需要大量的算力,是算力的“暴力美学”,而中国因中美芯片战短期内难以获得高端人工智能芯片。这将拖累中国大模型的发展。经过一年多的喧嚣,中美两国人工智能产业界的细微差异展现了出人预料,却又在情理之中的结果。

开源大模型的大量出现,使得美国在算法上的领先优势体现得远没有想象得那么大。既然很多大模型开源了,也就没有太大的“跟得上还是跟不上”的问题。

随着大模型向细分领域迅速落地,最初只关注于互联网数据的情况得以迅速改变。如果是应用于特定的行业细分领域,需要喂给大模型的数据都是在应用环境里,而不是在以网站为基础的互联网上。这样本地应用环境里的封闭数据就占据了数据来源的绝对优势。

如果设想的应用目标是无所不包、无所不能的大模型,这个算力需求的确是会上天的。但如果只是把大模型看作一个平台和工具,真正落地是要靠不断从无所不包的全域数据向不断细分的领域进行专业化。在这个过程中需要建立的参数量和算力需求就会呈数量级的减少。通用大模型加上行业小模型,甚至在此基础上进入更加落地到具体客户应用环境里的微模型,算力需求并不是向极大化方向爆炸性增长。并且,由于特定行业领域的数据质量,本身就是经过严格清洗的,远比互联网上的数据质量高得多,垃圾信息相对较少。因此,这类产品可以在高度智能化、产品可靠性和算力成本之间获得一个非常好的平衡。

以上讨论并不止是理论分析,中国企业如宇视等已经很好地解决了以上问题。

事实上,2023年5月9日,宇视科技就基于AIoT(人工智能物联网)应用发布了行业大模型“梧桐”。这个行业大模型本身就是针对CV(计算机视觉)行业、NLP(自然语言处理)进行裁剪和优化的。这在极大降低算力需求基础上却增大了产品化的程度和产品可靠性。在必然要面对的分布式能源与算力结合的趋势上,也成为宇视向非安防领域发力的一个机会窗。经过近一年的迭代和优化。在今天的合作伙伴大会上,宇视展示了系列化的大模型产品技术。

三、装备大模型化为什么远比大模型装备化更容易成功

张鹏国总裁介绍说,在过去,就有+AI还是AI+的争论。现在又有装备大模型化还是大模型装备化的争论。这两个争论的区别,简单说就是在原有成熟产品基础上增加人工智能或大模型,还是在拥有人工智能或大模型基础上做产品。人工智能只是一个功能性的工具,在任何一个实用化的领域,要做成产品需要远远超过单纯人工智能的其他产品技术特性。因此,在已有的成熟产品基础上增加相对成熟的人工智能技术,显然要远远比在单纯的人工智能功能模块基础上做具体产品要容易得多。这并不是说在充分掌握人工智能技术的基础上做产品不行,而是双方研发工作量和难度的差异。

四、大模型使细分领域的需求满足更加容易

2023年,宇视喊出一个口号:一切为了渠道,为了一切渠道, 为了渠道的一切。能够喊这个口号不仅仅是一个好的愿望,也是因为有内在能力支撑。正是因为有了梧桐大模型的支持,可以把很多针对非常细分、过去难以支持的应用,通过梧桐大模型交给渠道去做。这样就使过去难以满足的需求,现在就可以满足了。只有这样才能实现为了“一切渠道的一切需求”,使以上口号可以有效落地。为什么宇视大模型叫“梧桐”,是希望种下梧桐树,引得凤凰来。

五、产品定义失控与算力需求黑洞

美国的人工智能发展看似热闹,除了类似Alphafold预测蛋白质结构等获得显著成果外,至今并未看到有多少真正能扎扎实实落地的大模型应用。年初又引爆网络的Sora在赚足眼球的同时,不免让对人工智能发展历史深刻了解的人处于还是有些心里没底的状态。真的要让这种人工智能自动生存的视频达到实用化的程度,究竟还有多少距离,这个太难评估了。这是人工智能发展史上一个经常遭遇的难题:技术是一回事情,产品又是另外一回事情。任何一个在现实世界成功的实用产品,都需要在开发之前有清晰的产品功能、性能目标和产品实现的可靠性指标的定义。人工智能特别容易产生“产品定义失控”的问题。因为它太容易带给人们无限的想象空间了,很容易使打上人工智能标签的产品被赋予无限的功能和性能幻想。这样的功能在特定条件下“秀一下”,其表现可能是很诱人的,但当真的作为产品被客户部署以后,在使用中遇到各种难以提前预料和设想的无限复杂场景时,产品可能难以给用户带来预想中的体验。所谓产品定义失控,就是因为对智能本身研究的欠缺,人们往往并不清楚自己想象的人工智能产品究竟需要具备什么样的能力。以为6层楼房就是想象中的楼房,最后实际可能要建到600层才勉强能达到想象中的楼房样子。

之所以出现这种情况,更深入的原因是人工智能存在的算力需求黑洞问题。很多人工智能的算力需求人们很难确认它究竟需要多大,而在其他技术领域完全不是这样。例如在船舶领域,如果我们要造一艘能运载30万吨铁矿石的船舶,根据现在的船舶知识可以非常准确地计算出需要把船造多大,需要多厚的钢板,需要把船设计成什么样。对相应的能力需求是可以非常清楚的。无论进行某种精度的气象预报,还是某种程度的核爆炸计算机仿真模拟,我们是可以提前预测出需要多大运算量,从而要在特定时间内完成计算,我们可以预先估算出需要多大算力。

但是,如果想造出一个能够很好地实现人工智能自然语言翻译的机器,人们并没有可靠的数学模型准确计算出到底需要多大的算力。因此,20世纪五十年代,人们就误以为只要把字典输进当时的电脑,就可以实现自然语言理解和翻译。但事实证明人们对实现这个能力的算力需求估计差得实在是太离谱了。只到最近,自然语言的翻译,自然语音的理解才算达到实用化水平。而现在的计算设备与上个世纪50年代相比,如果按摩尔定律来计算,算力增长是超过10万亿倍。大多数我们设想中的人工智能功能都是类似的,我们并不清楚要使它们达到实用化的水平,需要的算力究竟会有多大,只有通过实际工程中不断尝试,最终成功地商用化以后,人们才清楚知道算力需求的结果是什么。很多时候看起来好像差一点点就可以使某个人工智能应用商用化了,但事实上为了弥补表面上差距不大的性能表现,实际所需要的算力增长远远超过预期。问题稍微复杂一点点,计算的需求就会需要很多个数量级地增长。

我们可以清楚地知道某个人工智能芯片可以进行多少个大模型参数的训练,但要想解决某个特定的人工智能问题,到底需要多少万亿参数才能达到实用化的水平,现在并没有确切的数学模型可以算出来。

因此,历史上真正成功的人工智能产品,往往是技术往无限增强的方向去扩展和想象,实际应用却都是对当前的人工智能技术进行限定、裁剪、问题简化、高度缩小的清晰产品功能和性能定义而获得。通过这种方式极大降低算力需求,从而使得当前的芯片性能可以使相应的产品功能得以有效商用化。

人工智能计算机视觉会去努力解决一切图像和视频的识别与处理问题,但在实用中,对相对规范的车辆号牌信息、车辆颜色型号、司机是否系安全带、人脸、印刷文字等高度限定或规范化的图像信息识别问题,相应产品就较早获得实际应用。目前对自然语音、鲜花、植物、动物等识别也获得较好的结果。

由于摩尔定律的逐步失效,算力的增长越来越放缓。因此,人工智能不仅不会带来革命、出现奇点,而且因算力增长越来越困难和缓慢,更加需要采用另一个方向的努力:简化问题和缩减目标范围,以使得所需要的算力获得数量级的降低。只有这样才能使人工智能有效商用化。

关于人工智能的本质,有统计派和推理派的分歧。现在的人工智能,无论是深度学习还是现在的大模型,本质上都只是一种统计。这种技术路线的问题有两个,一个是需要大量的算力和数据,第二它永远是一种概率性的结果,在可靠性上存在提升的天然障碍。

我非常同意张鹏国总裁在大会上的观点:大模型技术只是升级不是革命。革命是秩序从上到下的颠覆。但大模型至今为止并没有显示出这种颠覆。对于这个观点,从宇视发布梧桐大模型时我就与宇视各位领导反复交流过。在这次大会之前与张鹏国总裁等宇视领导的交流中,我也支持这样的看法。

大会演讲照片

张鹏国总裁演讲全文可参见:宇视张鹏国:AIGC千里之行,始于足下

由于美国在工业领域空心化太严重,因此人工智能可以落地的应用领域已经相当有限。而中国产业领域极为丰满和完备,拥有一切人工智能可能落地的行业细分领域。这是中国可以在人工智能领域突围乃至部分领先的巨大优势所在。4月2日,在2024赛迪论坛开幕式主论坛上,第十四届全国政协常委、经济委员会副主任苗圩引用专家的话提到,中国应该利用大模型来赋能中国制造业,赋能各个具体领域,来实现中国人工智能的应用,从而实现差异化的发展道路。

在大模型出来之前,各种应用早已经覆盖几乎所有市场,宇视的选择是工具和装备的大模型化。大模型会催生大量细分市场小场景的应用,所有产品都需要再做一遍技术升级。中国会很快实现这种技术升级。会上,宇视科技首席AI科学家李聪廷发布了梧桐2.0

宇视科技首席产品官朱兵总介绍了极为丰富的大模型产品应用案例,不仅让人大开眼界,而且让人深为感叹大模型的应用原来如此之广泛。

对特定的场景进行训练以后,可以:

发现不安全的加油方式。

出门遛狗没带狗绳。

汽车生产过程中各种不规范操作识别。

......

另一个展示的应用让人深为动容,宇视与国际爱护动物基金会ifaw合作,将大模型用于珍稀动物的保护和救治。

要谈人工智能,先得搞清楚以下问题:

是将大模型用于保护珍稀动物,还是用于生成一篇糊弄上级和员工的报告?

用于学生体育锻炼,还是用于替学生答题?

用于自动生成游客旅游过程的VLOG,还是用于生成虚幻的视频?

用于生产过程的安全检测,还是用于生成莫名其妙的图片?

用于发现新材料,还是用于替研究生写论文?

......

不仅是现在的人工智能技术本身有幻觉,太多人讨论人工智能的态度和出发点就存在幻觉。大模型炒作一番之后,人们会发现其结果是中国的社会生活和生产全面大模型化了,而美国却还生活在非人工智能时代,甚至是模拟时代。

本文来源:纯科学 微信公众号